文 / 中国互联网金融协会 肖翔 周钰博 何君荷

中国人民银行金融科技委员会于2021年2月召开会议总结2020年工作,研究部署2021年重点任务。会议首次提出将“推动金融领域科技伦理治理体系建设”作为重点任务,体现了金融管理部门对金融科技应用伦理规范的高度重视。2021年3月,《人工智能算法金融应用评价规范》(JR/T 0221-2021)金融行业标准发布实施,从安全性、可解释性、精准性和性能等方面对人工智能算法金融应用评价进行规范,进一步丰富了我国金融领域人工智能伦理治理的标准体系。国际上,部分国家在金融科技应用伦理规范方面也开展了一些有益探索,其中新加坡在人工智能方面的做法较为典型。2018年以来,为推动金融机构负责任和合乎道德地应用人工智能和数据分析,新加坡金融管理局采取了一系列措施,如成立专门委员会、发布应用原则、建立评估框架等,相关工作成果具有较强的参考借鉴价值。本文对新加坡人工智能金融应用伦理规范工作进展进行系统梳理,以及为我国推动金融领域科技伦理治理体系建设提供政策启示。

主要背景

2018年4月,新加坡金融管理局宣布,其组建的公平、道德、可问责和透明(fairness,ethics,accountability and transparency,即FEAT)委员会与金融领域、数据分析领域的学者、实践者等利益相关者合作,制定了一项旨在促进金融机构负责任和合乎道德地使用人工智能和数据分析(AIDA)的指南,并就该指南公开征求意见。

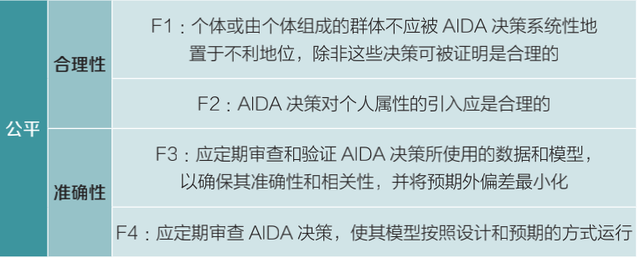

2018年11月,新加坡金融管理局发布《促进新加坡金融业公平、道德、可问责和透明地使用人工智能和数据分析的原则》,标志着FEAT原则正式发布。当前版本于2019年2月更新。其中,公平性原则包括4条具体内容(见表1)。

表 1 公平性原则的主要内容

2019年11月,新加坡金融管理局宣布与金融行业合作创建了Veritas框架,旨在帮助金融机构根据FEAT原则评估其AIDA解决方案,促进其负责任地采用AIDA。

2020年5月,新加坡金融管理局宣布启动Veritas第一阶段,制定信用风险评分和客户营销两个场景的公平性指标,帮助相关金融机构评估其AIDA解决方案的公平性。

2021年1月,新加坡金融管理局宣布Veritas第一阶段圆满结束,并发布《FEAT公平性原则评估方法》(简称《方法》)。同时,新加坡金融管理局还宣布将启动Veritas第二阶段,为信用风险评分和客户营销场景开发道德、可问责和透明等方面的评估方法,以及将对公平的评估方法拓展到保险领域。

FEAT公平性原则及其评估方法

1.参与主体

《方法》将参与主体分为AIDA系统的开发者、所有者、评估者及金融机构。其中,开发者负责系统研究开发,可能是金融机构、技术供应商或金融科技公司等;所有者使用AIDA系统辅助决策,可能是金融机构的业务团队;评估者对金融机构所提供的公平性评估材料进行评估,可能是外部审计机构,也可能是内部的模型风险管理部门或内部审计组;金融机构是对系统负责的参与方。需要注意的是,所有者属于金融机构,并代表其进行操作;在系统由内部开发的情况下,开发者也是金融机构的一部分;同样,评估者也可能从属于金融机构。

2.评估流程

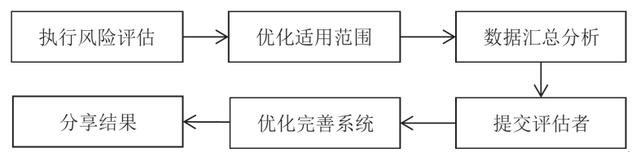

《方法》的主要思路是,围绕监管关注点提出问题并给出解答问题所需的具体考虑事项,由系统所有者根据实际情况完成解答(其答案应该能为评估者提供必要的信息和分析,帮助评估者判断是否符合FEAT公平性原则),再由评估者根据所有者提供的材料完成评估,其一般流程如下。

图1 应用FEAT公平性评估方法的流程

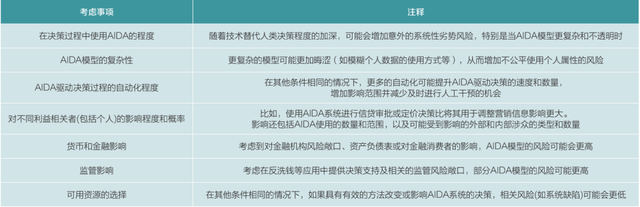

第一,AIDA系统所有者根据其风险管理流程等确定系统是否在适用范围内。若是,则进一步完成风险评估,并确定适当的定制化方法。其中,风险评估的结果可能是将AIDA系统归入低、中、高等特定风险级别,确保具有相似风险级别的模型得到相似处理,并通过适当的定制化方法分配更多的评估资源给风险更高的系统(见表2)。

表 2 风险评估的考虑事项

第二,所有者向评估者(根据风险级别选择)提供摘要,以便在必要时进一步细化评估的范围,如就系统的边界及评估方法中哪些元素与系统相关等达成一致。

第三,所有者、开发者合作收集信息、执行相关分析,基于系统风险级别给出《方法》中部分或全部问题的答案。

第四,所有者将分析结果提交给评估者,由后者根据该分析结果判断系统是否符合FEAT公平性原则。

第五,根据评估者的反馈,所有者与开发者一起对系统进行适当更改。

第六,在处理了内部反馈后,还可将评估结果和据此采取的行动共享给有关监管机构等外部利益相关者。

3.评估重点

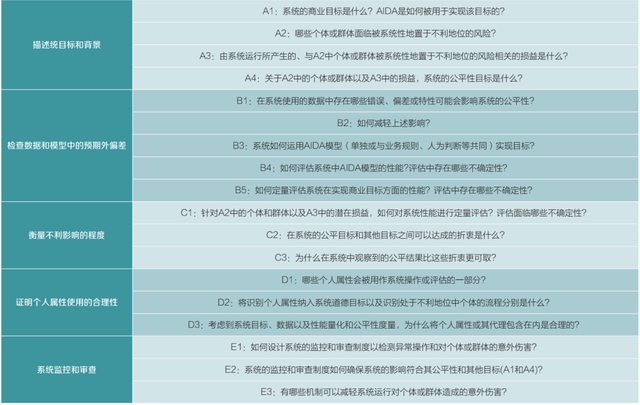

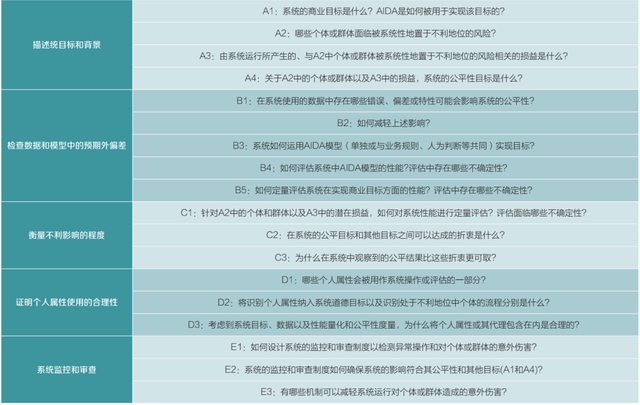

《方法》主要关注系统目标、数据和模型、系统影响度量、个人数据使用、持续监测五个方面(见表3)。

表 3 风险评估的考虑事项

一是描述系统目标和背景,旨在明确系统目标及相关约束条件(如合规等内外部限制)、可能被系统置于不利地位的个体或群体,以及上述个体或群体可能遭受的损益。

二是检查数据和模型,如样本代表性、测量误差、作为输入数据的其它模型结果的准确性、代理变量选择的合理性,旨在确保其准确性、相关性且没有预期外的偏差。

三是衡量不利影响的程度,要求所有者检查其认为的相关客户潜在损益,评估这些损益的分布情况,旨在明确系统决策在多大程度上使得个人或群体处于不利地位。

四是论证个人属性使用的合理性,要求所有者列出其认为可能涉及的个人属性,解释其选择是如何体现系统目标和相关约束的,且在个人属性的使用缺少法律或内部规定等约束的场景,也可根据对系统性能的影响以及已采取的公平性措施等论证其合理性。

五是系统监控和审查,聚焦影响系统的技术故障、决策规则和人工干预等,旨在防范系统性能随时间推移而下降,或在后续操作中产生设计阶段并不明显的预期外后果。

表 3 风险评估的考虑事项

政策启示

一是加强金融科技伦理规范可探索更加灵活、柔性的方式。《方法》认为,消除所有形式的不公平是不可能的,且公平性只是系统众多竞争性目标之一,解决公平问题并不是要“使系统公平”,而是根据运营者选择的公平目标改进系统,并确保这些目标符合其所处社会的价值观。新加坡金融管理局对《方法》的定位并非强约束的规则或标准,而是旨在引导金融机构明确提出控制系统公平性的目标和约束条件,并通过必要的分析帮助利益相关者评价系统在实现相关目标方面的表现。同时,新加坡金融管理局指出,相关评估结果并不妨碍新加坡金融管理局以监管机构的身份评估金融机构对FEAT原则的执行,并在适当情况下提出改进建议。考虑到道德伦理具有重要意义但通常难以明确界定和量化,其管理可能需要更加灵活、柔性的方式。

二是加强金融科技伦理规范需引导金融机构发挥更多主动性。在公平性目标设定、AIDA系统定义、系统风险等级评估等方面,《方法》赋予了金融机构较大自主性。比如,金融机构对相关问题的解答是开展评估的重要依据,且评估者可由金融机构内部组织担任,甚至在某些情况下整个评估过程均可在金融机构内部完成;由于AIDA系统是一组宽泛的技术且没有标准定义,金融机构可在其风险管理框架的范围内构建一个内部定义;金融机构可根据预先定义的标准评估系统相关风险,FEAT原则应根据特定系统的风险调整其适用性,“金融机构可基于AIDA驱动决策的重要性在其内部治理框架下校准行动和需求”。

三是在AIDA系统中使用个人信息可能是难以避免的,但需证明其合理性。《方法》认为,由于数据中存在“冗余编码”,模型可通过其他变量推测出个人属性,不可能从AIDA系统中完全剔除个人属性。同时,当某些个人属性对个体有利时,将其排除在决策依据外反而可能导致更多歧视。因此,设计更公平的AIDA系统,应依赖于“算法公平”等新兴领域正在开发的数据处理和建模方法,而非简单地删除可能导致歧视的信息。同时,《方法》强调金融机构在系统中引入个人属性或其代理变量时,应论证其合理性。

此外,《方法》中强调与金融机构现有风险管理流程相结合、根据风险级别对方法进行适当调整、兼顾金融机构商业目标和道德目标、注意审视原始数据中隐含的歧视、主张对系统进行持续监控和审查等做法也具有一定的借鉴意义。

(栏目编辑:王伟)